Mientras el resto de la industria informática lucha por conseguir un exaflop de procesamiento, Nvidia está a punto de superar a todos con un superordenador de 18 exaflops impulsado por una nueva arquitectura de GPU.

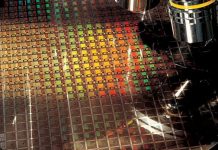

La GPU H100, que se espera que llegue al mercado en el tercer trimestre del año, tiene 80.000 millones de transistores (la generación anterior, Ampere, tenía 54.000 millones) con casi 5 TB/s de conectividad externa y soporte para PCIe Gen5, así como High Bandwidth Memory 3 (HBM3) que permite 3 TB/s de ancho de banda de memoria. Es la primera de una nueva familia de GPUs cuyo nombre en clave es Hopper, en honor a la almirante Grace Hopper, pionera de la informática que creó el lenguaje COBOL y acuñó el término «bug informático».

Esta GPU está destinada a alimentar centros de datos diseñados para manejar grandes cargas de trabajo de inteligencia artificial. La familia de GPUs Hopper también incluye la segunda generación de la tecnología Secure Multi-Instance GPU (MIG), propiedad de la compañía, que permite particionar una única GPU para dar soporte a la seguridad en usos multitarea. El cambio más importante introducido por la GPU H100 es que los MIG están ahora totalmente aislados y asegurados de forma independiente.

Los investigadores con cargas de trabajo más pequeñas tuvieron que alquilar una instancia completa de CSP A100 para el aislamiento. Sin embargo, con la GPU H100, pueden utilizar los MIG para aislar de forma segura una parte de la GPU, lo que garantiza la seguridad de sus datos. «Ahora esta potencia de cálculo se puede dividir de forma segura entre múltiples usuarios y arrendatarios de la nube», afirmó Paresh Kharya, director senior de Informática de Centros de Datos de Nvidia. «Hablamos más concretamente de siete veces más capacidades MIG en comparación con la generación anterior».

La novedad de la GPU H100 es una función denominada computación confidencial, que protege los modelos de inteligencia artificial y los datos de los clientes durante el procesamiento. Kharya señaló que actualmente los datos sensibles suelen estar cifrados en reposo y en tránsito por la red, pero a menudo no están protegidos durante su uso. La informática confidencial llena ese vacío protegiendo los datos en uso.

La arquitectura Hopper también integra NVLink de cuarta generación, la tecnología de interconexión de alta velocidad de Nvidia. En combinación con un nuevo conmutador NVLink externo, el nuevo NVlink puede conectar hasta 256 GPU H100 con un ancho de banda nueve veces superior al de la generación anterior.

Por último, Hopper añade nuevas instrucciones DPX para acelerar la programación dinámica, la práctica de descomponer problemas con complejidad combinatoria en subproblemas más sencillos. Se emplea en una amplia gama de algoritmos utilizados en genómica y optimización de grafos. Las nuevas instrucciones DPX de Hopper acelerarán la programación dinámica por un factor de siete.

La promesa del superordenador más rápido del mundo

Estas tecnologías se utilizarán para crear los sistemas Nvidia DGX H100, unidades de montaje en rack de 5U que son los bloques de construcción de los potentes superordenadores DGX SuperPOD. Kharya afirmó que el nuevo sistema DGX H100 ofrecerá un rendimiento de IA de 32 petaflops, seis veces más que el DGX A100 actualmente en el mercado. Y, cuando se combine con el sistema de conmutación NVLink, creará un DGX SuperPOD de 32 nodos que ofrecerá un exaflop de rendimiento de IA y un ancho de banda de bisección de 70 terabytes por segundo, 11 veces más que el DGX A100 SuperPOD.

Para mostrar las capacidades del H100, Nvidia está construyendo un superordenador llamado Eos con 18 DGX H100 SuperPODs (esto es, 4.608 GPUs H100 unidas por NVLink y conmutadores InfiniBand de cuarta generación), para un total de 18 exaflops de rendimiento de IA. Según la última lista de superordenadores Top500, el rendimiento máximo en 8 bits del superordenador más rápido del mundo, Fugaku, alcanza los cuatro exaflops; por tanto, Nvidia promete ir cuatro veces más rápido.

Eos proporcionará un rendimiento bare metal con aislamiento multi-tenant, así como un aislamiento del rendimiento para garantizar que una aplicación no afecte a la otra. «Eos será utilizado por nuestros equipos de investigación de inteligencia artificial, así como por otros numerosos ingenieros y equipos de software que están construyendo nuestros productos, incluyendo la plataforma de vehículos autónomos y el software de inteligencia artificial conversacional», concluye Kharya.

Nvidia aún no ha especificado un plazo para el lanzamiento de Eos, mientras que el DGX H100 POD y el SuperPOD se esperan para finales de año.

Redacción CambioDigital OnLine